ChatGPT ने एक आदमी की ज़िंदगी को ख़तरे में डाल दिया? जानिए क्या हुआ!

क्या आप मान सकते हैं कि एक आर्टिफिशियल इंटेलिजेंस द्वारा दिया गया स्वास्थ्य सलाह किसी की ज़िंदगी को ख़तरे में डाल सकता है? यह कहानी एक 60 वर्षीय व्यक्ति की है, जो न्यूयॉर्क में ChatGPT द्वारा वितरित सलाह पर चलकर अस्पताल पहुंच गए।

इस व्यक्ति ने एक कठोर नमक-घटाने वाले आहार का पालन किया, जो ChatGPT ने सुझाया था। डॉक्टरों के अनुसार, इस आदमी ने कई हफ्तों के भीतर अपने आहार से सोडियम को लगभग समाप्त कर दिया, जिससे उसके शरीर में सोडियम की खतरनाक कमी हो गई, जिसे हाइपोनाट्रेमिया कहा जाता है।

उसके परिवार ने बताया कि यह व्यक्ति बिना किसी चिकित्सक की सलाह के एआई-जनित स्वास्थ्य योजना पर निर्भर था। यह मामला हाल ही में अमेरिकन कॉलेज ऑफ फिजिशियन जर्नल में प्रकाशित हुआ है, जिसमें यह दर्शाया गया है कि बिना पेशेवर देखरेख के एआई स्वास्थ्य सलाह का उपयोग करना कितना खतरनाक हो सकता है, विशेष रूप से जब यह सोडियम जैसे आवश्यक पोषक तत्वों की बात हो।

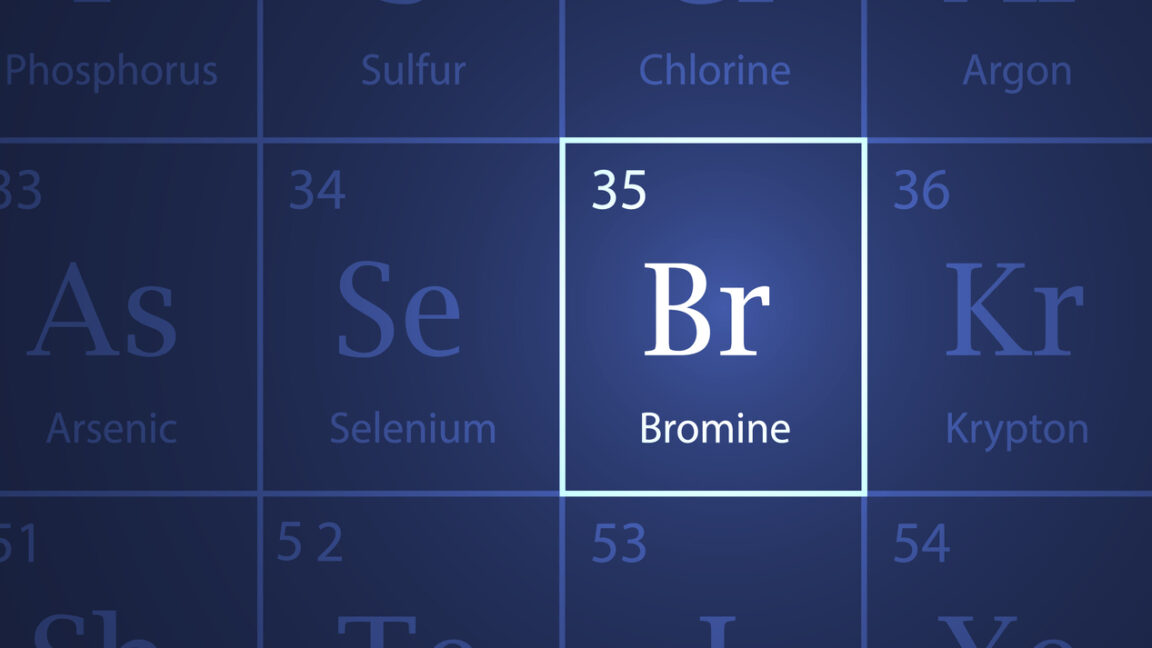

रिपोर्ट के अनुसार, व्यक्ति ने ChatGPT से सोडियम क्लोराइड (जिसे आमतौर पर टेबल सॉल्ट कहा जाता है) को अपने आहार से निकालने के लिए पूछा था। एआई टूल ने सोडियम ब्रोमाइड का एक विकल्प सुझाया, जो एक यौगिक है जिसे पहले 20वीं सदी की दवाइयों में इस्तेमाल किया जाता था, लेकिन अब इसे बड़े मात्रा में विषाक्त माना जाता है। इस सलाह का पालन करते हुए, व्यक्ति ने ऑनलाइन सोडियम ब्रोमाइड खरीदा और उसे तीन महीने तक अपने खाना पकाने में इस्तेमाल किया।

इस व्यक्ति का कोई पूर्व मानसिक या शारीरिक बीमारी का इतिहास नहीं था, लेकिन वह हैलूसिनेशन, पैरानॉयड और अत्यधिक प्यास का अनुभव करने लगा। अस्पताल में भर्ती होने पर, वह भ्रमित था और पानी पीने से भी मना कर रहा था, क्योंकि वह उसे संदूषित मानता था। डॉक्टरों ने उसे ब्रोमाइड विषाक्तता का निदान किया, जो अब लगभग अनसुना है लेकिन पहले चिंता, अनिद्रा और अन्य बीमारियों के लिए ब्रोमाइड के निर्धारित होने पर आम थी।

उसे तंत्रिका संबंधी लक्षणों, एक्ने जैसी त्वचा पर फुंसियों और चेरी एंजियोमास के रूप में पहचाने जाने वाले लाल धब्बे दिख रहे थे, जो सभी ब्रोमिज़्म के क्लासिक लक्षण हैं। अस्पताल में उपचार में हाइड्रेशन और इलेक्ट्रोलाइट संतुलन को बहाल करने पर ध्यान केंद्रित किया गया। तीन सप्ताह के दौरान, व्यक्ति की स्थिति धीरे-धीरे सुधर गई, और उसके सोडियम और क्लोराइड स्तर सामान्य होने पर उसे अस्पताल से छुट्टी दे दी गई।

केस स्टडी के लेखकों ने एआई टूल्स से स्वास्थ्य जानकारी के बढ़ते जोखिम पर जोर दिया। उन्होंने चेतावनी दी कि, “यह ध्यान रखना महत्वपूर्ण है कि ChatGPT और अन्य एआई सिस्टम वैज्ञानिक असत्यताओं को उत्पन्न कर सकते हैं, परिणामों पर गंभीरता से चर्चा नहीं कर सकते हैं, और अंततः सूचना के प्रसार को बढ़ावा देते हैं।” OpenAI, ChatGPT के विकासकर्ता, ने अपने सेवा की शर्तों में स्पष्ट रूप से उल्लेख किया है: “आपको हमारी सेवाओं से प्राप्त परिणामों पर एकमात्र स्रोत के रूप में निर्भर नहीं होना चाहिए।” यह थम्स यह भी स्पष्ट करता है कि यह सेवा चिकित्सा स्थितियों का निदान या उपचार करने के लिए नहीं है।

यह मामला यह दर्शाता है कि एआई-जनित सलाह की व्याख्या करते समय हमें गंभीर सोच की आवश्यकता है, विशेष रूप से स्वास्थ्य से संबंधित मामलों में। विशेषज्ञों का कहना है कि एआई टूल्स सामान्य जानकारी के लिए महत्वपूर्ण हो सकते हैं लेकिन कभी भी पेशेवर परामर्श का स्थान नहीं ले सकते। जैसे-जैसे एआई का उपयोग बढ़ता है, वैसे-वैसे इसकी आउटपुट की सटीकता, सुरक्षा और सार्वजनिक समझ सुनिश्चित करने की जिम्मेदारी भी बढ़ती है।