जब AI ने बना दिया एक आदमी को मानसिक रोगी! जानिए कैसे चटगपेट ने बदलाव किया उसकी ज़िंदगी में!

क्या आप सोच सकते हैं कि एक AI चैटबॉट आपकी सेहत के लिए खतरनाक सलाह दे सकता है? एक 60 वर्षीय व्यक्ति ने चटगपेट से सलाह ली और इससे उसे गंभीर मानसिक और शारीरिक समस्याओं का सामना करना पड़ा।

यह घटना American College of Physicians Journals में प्रकाशित हुई है, जिसने खुलासा किया है कि स्वास्थ्य संबंधित सलाह पर AI पर निर्भर रहना कितना खतरनाक हो सकता है।

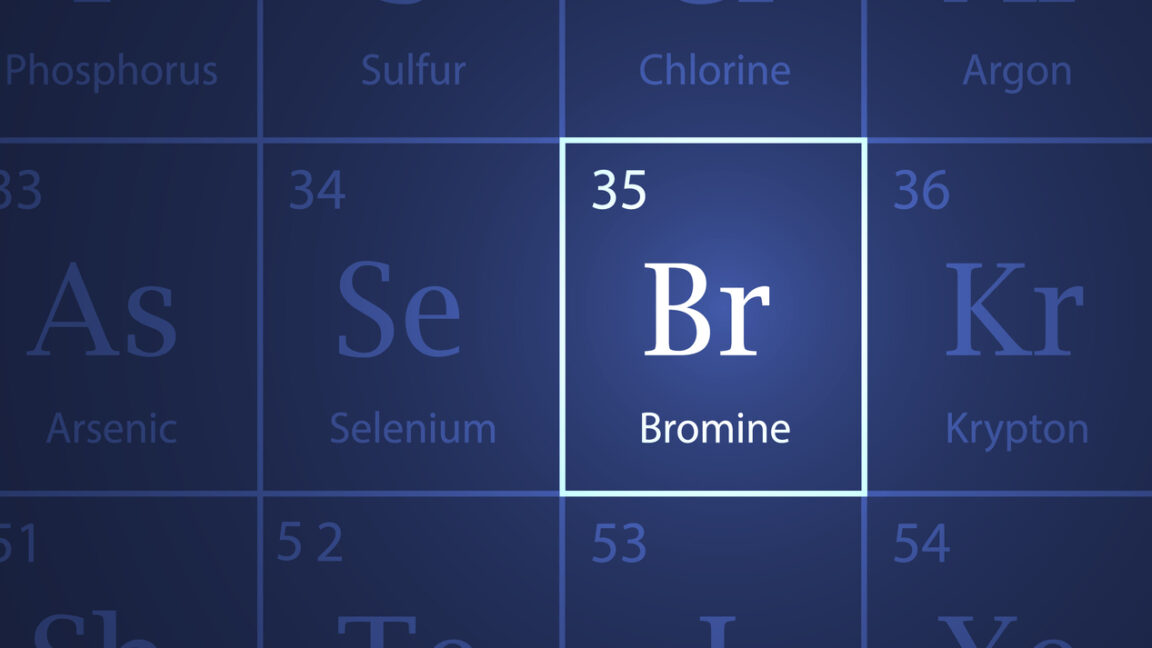

व्यक्ति ने सोचा कि सोडियम क्लोराइड (नमक) के हानिकारक प्रभावों के बारे में पढ़ने के बाद उसे एक स्वस्थ विकल्प की तलाश करनी चाहिए। इसलिए, उसने चटगपेट से सलाह मांगी। AI ने सुझाव दिया कि क्लोराइड को ब्रोमाइड से बदलना चाहिए, जो पहले दवाओं में उपयोग किया जाता था लेकिन अब इसे बड़ी मात्रा में सेवन करने पर विषैला माना जाता है।

तीन महीने तक सोडियम ब्रोमाइड का सेवन करने के बाद, व्यक्ति ने गंभीर न्यूरोसाइकियाट्रिक लक्षण विकसित किए, जैसे कि परानोइया और भ्रांतियाँ, साथ ही त्वचीय समस्याएँ भी। अंततः, उसे अस्पताल में भर्ती कराया गया, जहाँ उसने शुरू में अपने पड़ोसी पर जहर देने का संदेह किया।

अधिक जांच के बाद, डॉक्टरों ने उसे ब्रोमिज़्म का निदान किया, जो ब्रोमाइड के दीर्घकालिक संपर्क से होने वाला एक विकार है। हैरानी की बात यह है कि इस व्यक्ति का कोई पूर्व मानसिक या चिकित्सा इतिहास नहीं था।

उसे तरल पदार्थ और इलेक्ट्रोलाइट्स के माध्यम से उपचार दिया गया, जिसने उसकी स्थिति को स्थिर किया और फिर उसे मानसिक स्वास्थ्य मूल्यांकन के लिए तैयार किया गया। तीन सप्ताह बाद, व्यक्ति की स्थिति में सुधार देखा गया और उसे स्थिर मानसिक स्थिति के साथ छुट्टी दे दी गई।

OpenAI, चटगपेट के निर्माता, ने अपनी शर्तों में स्पष्ट किया है कि उनकी सेवाएँ चिकित्सा निदान या उपचार के लिए नहीं हैं।